StreamWorks 6.0.2更新日志

发布时间:2023-04-11

新增

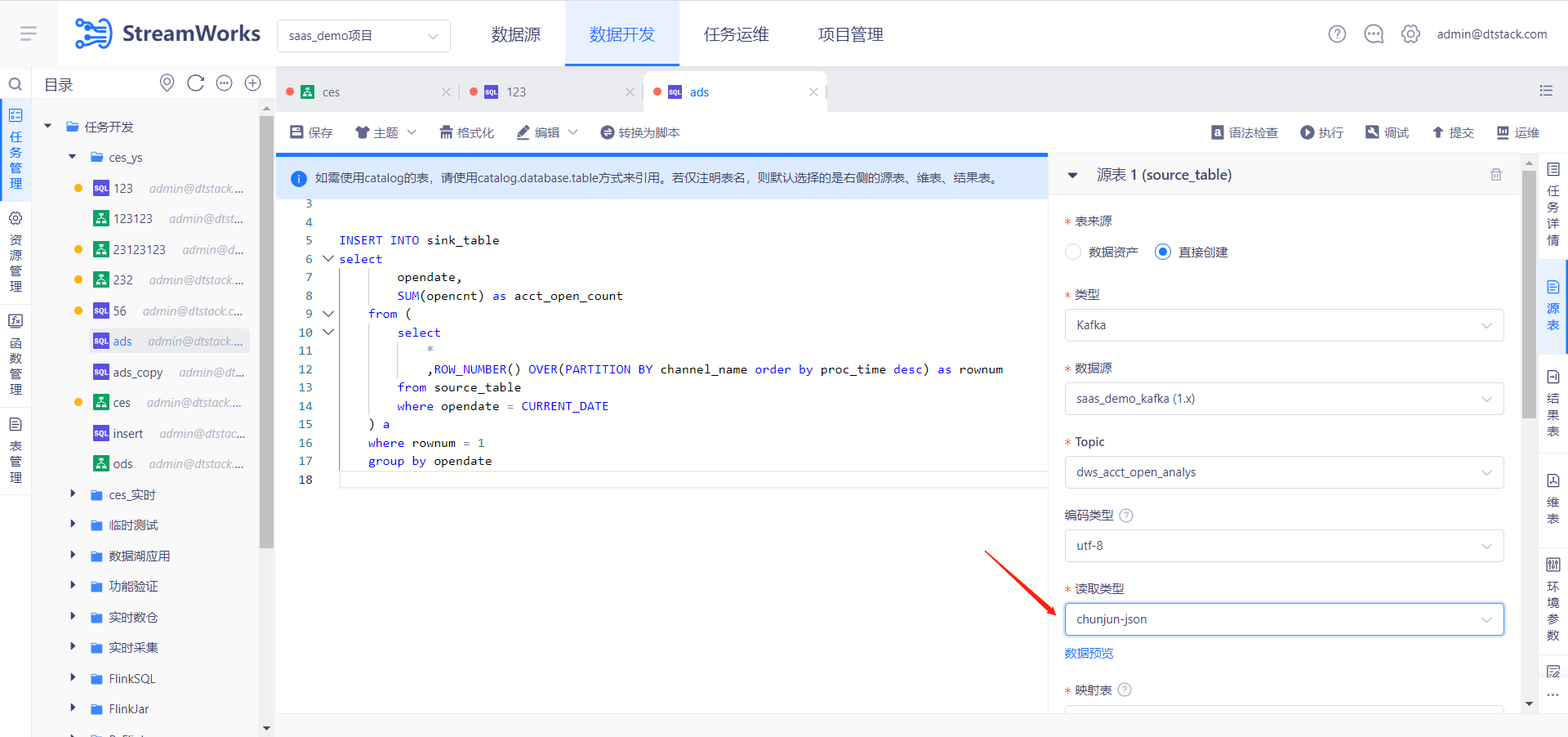

【FlinkSQL】FlinkSQL开发,Kafka chunjun-json支持自动映射【5.3】

- 背景:我们上个迭代已经支持了OGG-JSON的自动映射,本次迭代支持了实时平台自身采集工具打到Kafka的格式(chunjun-json)

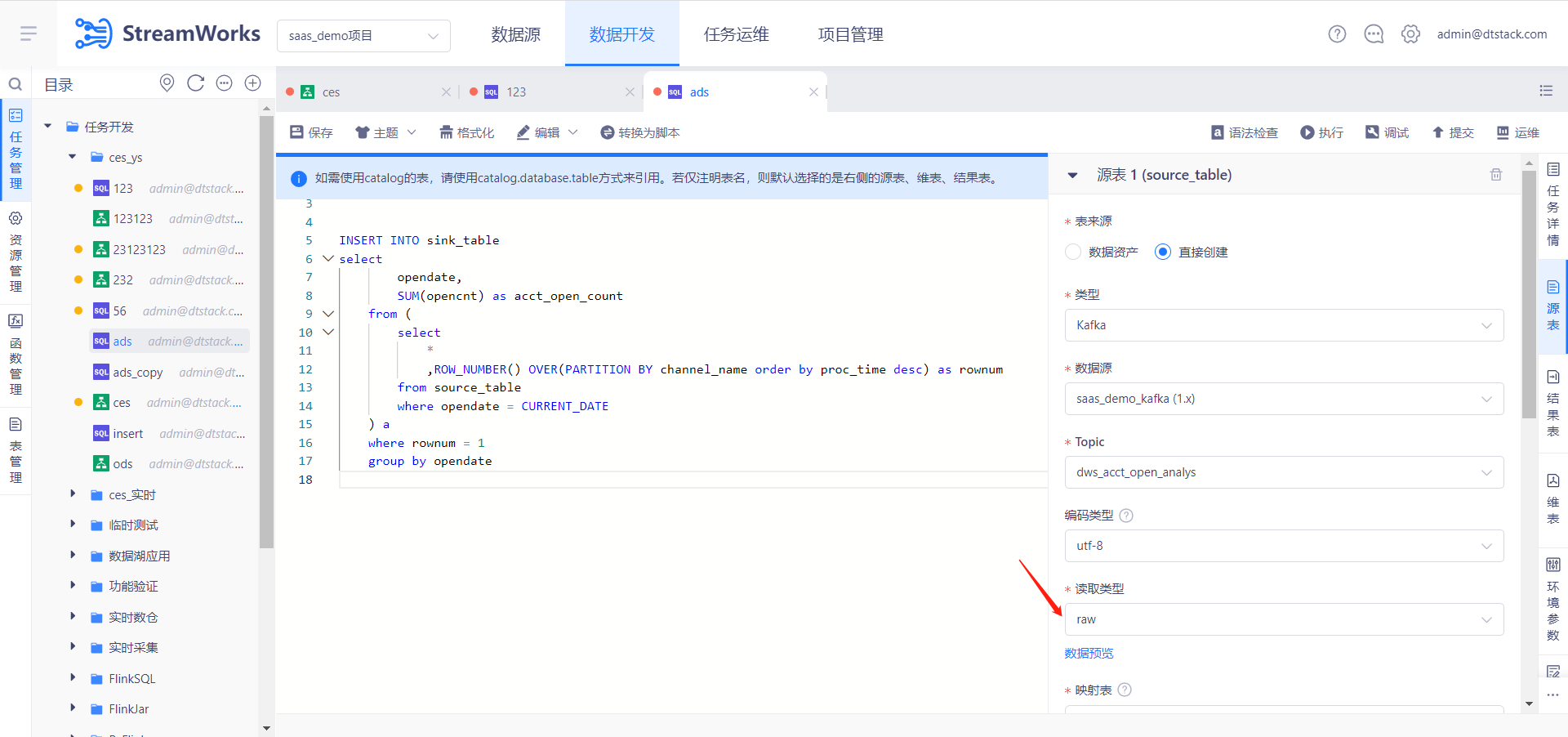

【Kafka Connector】Kafka读取类型新增Raw Format【5.3】

背景:如果你的Kafka 中具有原始日志数据,并希望使用 Flink SQL 读取和分析此类数据时,需要用到raw format。如:

47.29.201.179 - - [28/Feb/2019:13:17:10 +0000] "GET /?p=1 HTTP/2.0" 200 5316 "https://domain.com/?p=1" "Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.119 Safari/537.36" "2.75"限制:如果读取类型使用raw format,请避免使用upsert-kafka。因为raw format会将

null值编码成byte[]类型的null,而在upsert-kafka中会将null视为删除值的操作。

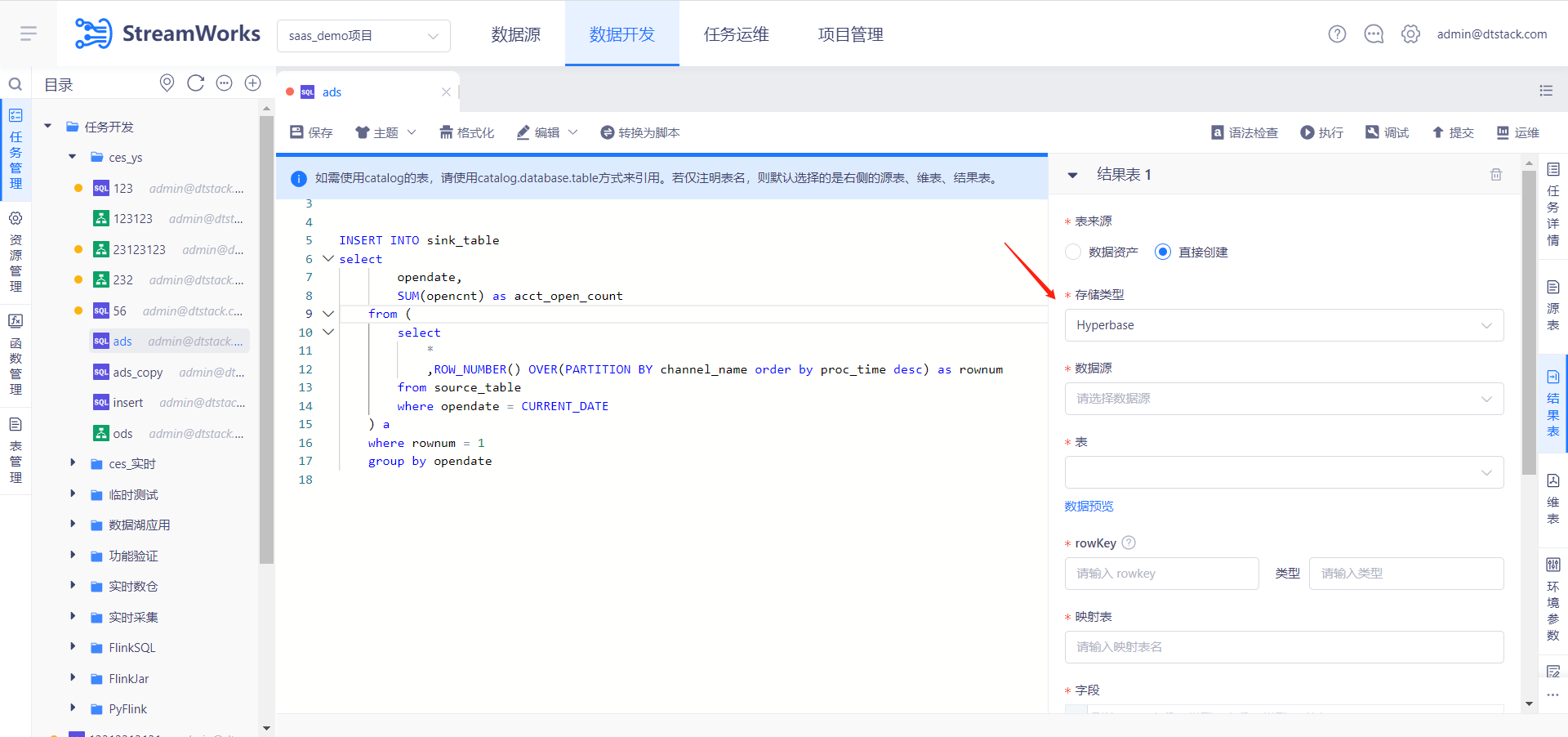

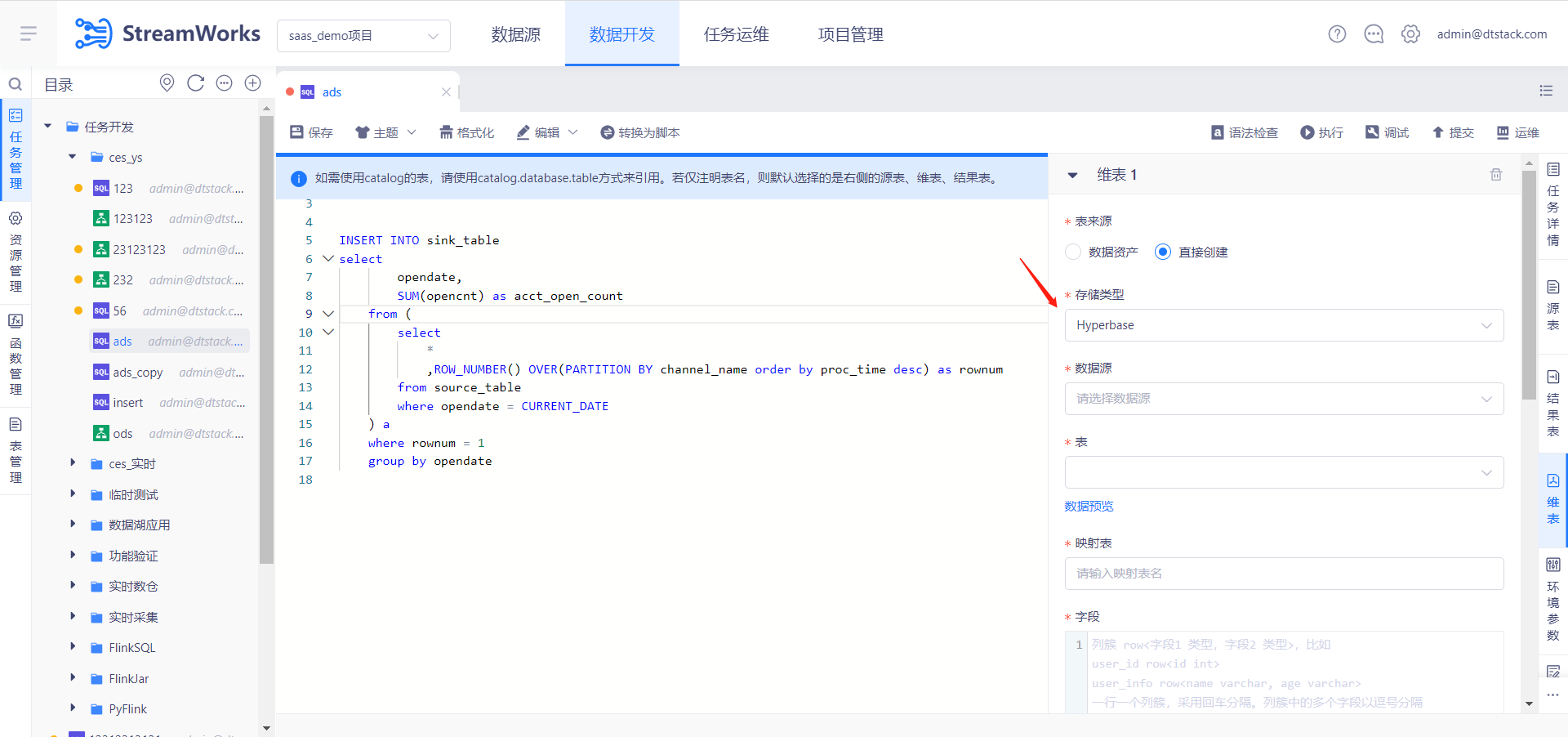

【Hyperbase】FlinkSQL维表、结果表新增Hyperbase数据源【5.3】

说明:Flink1.12,向导模式

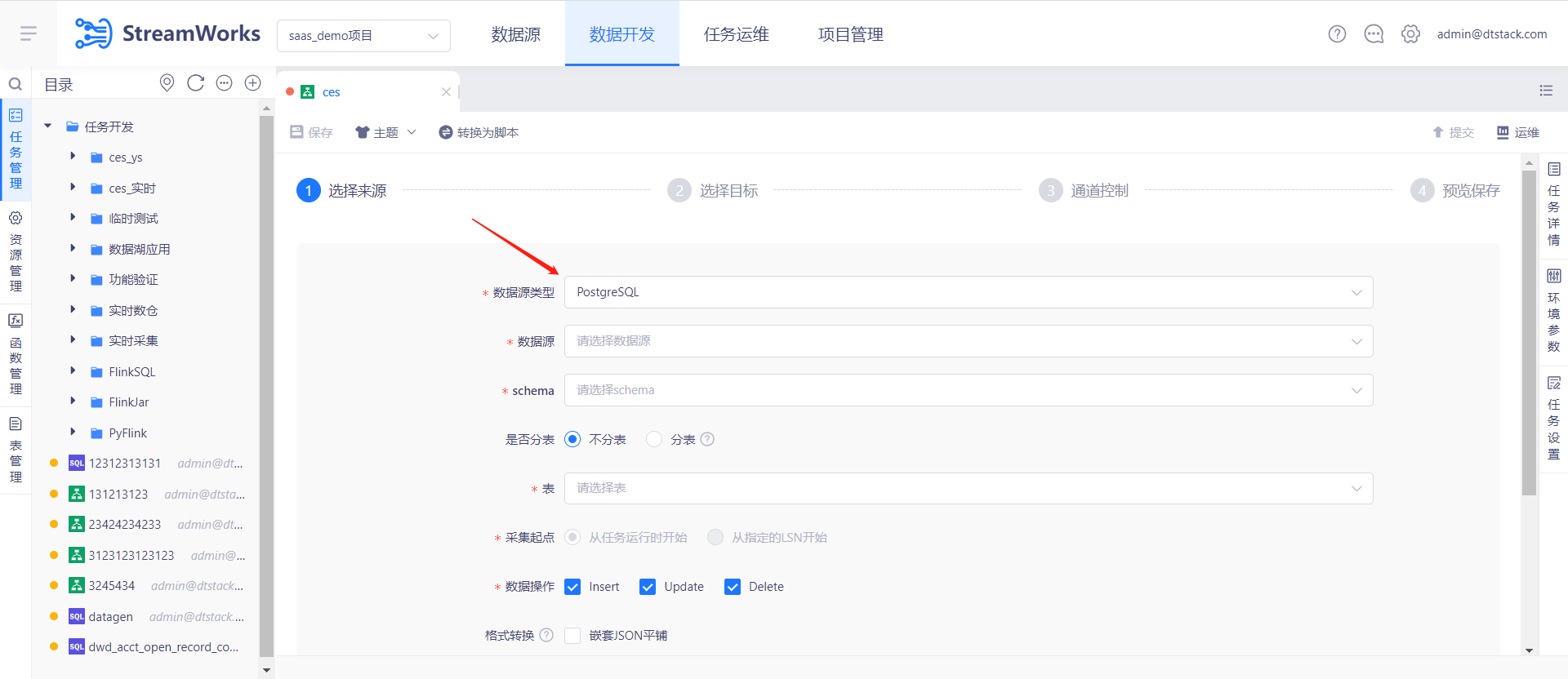

【PGWal】Flink1.12中重构PGWAL插件【5.3】

说明:Flink1.10已支持过PGWal插件,之前插件迁移1.12的时候,漏测了PGWal。目前在Flink1.12上测试发现存在比较大的问题,就顺便重构了。

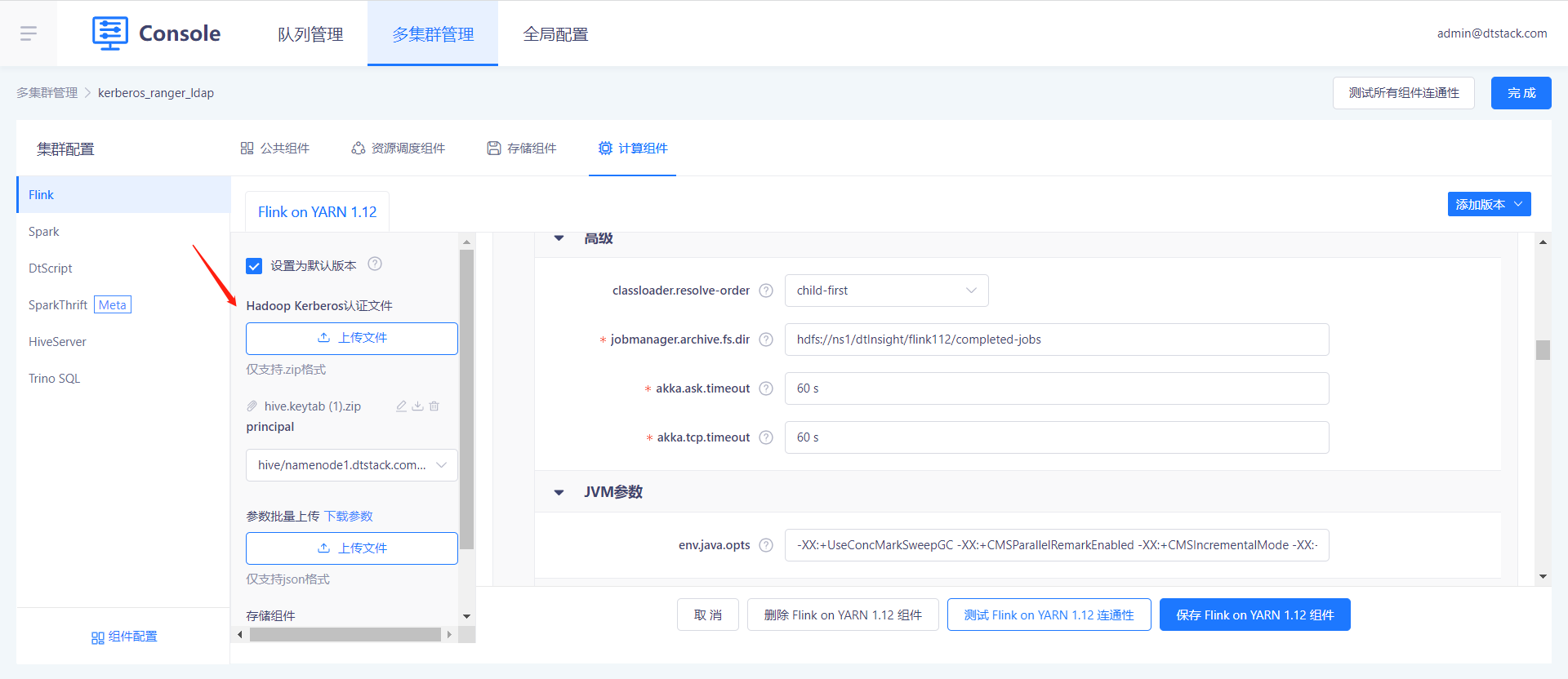

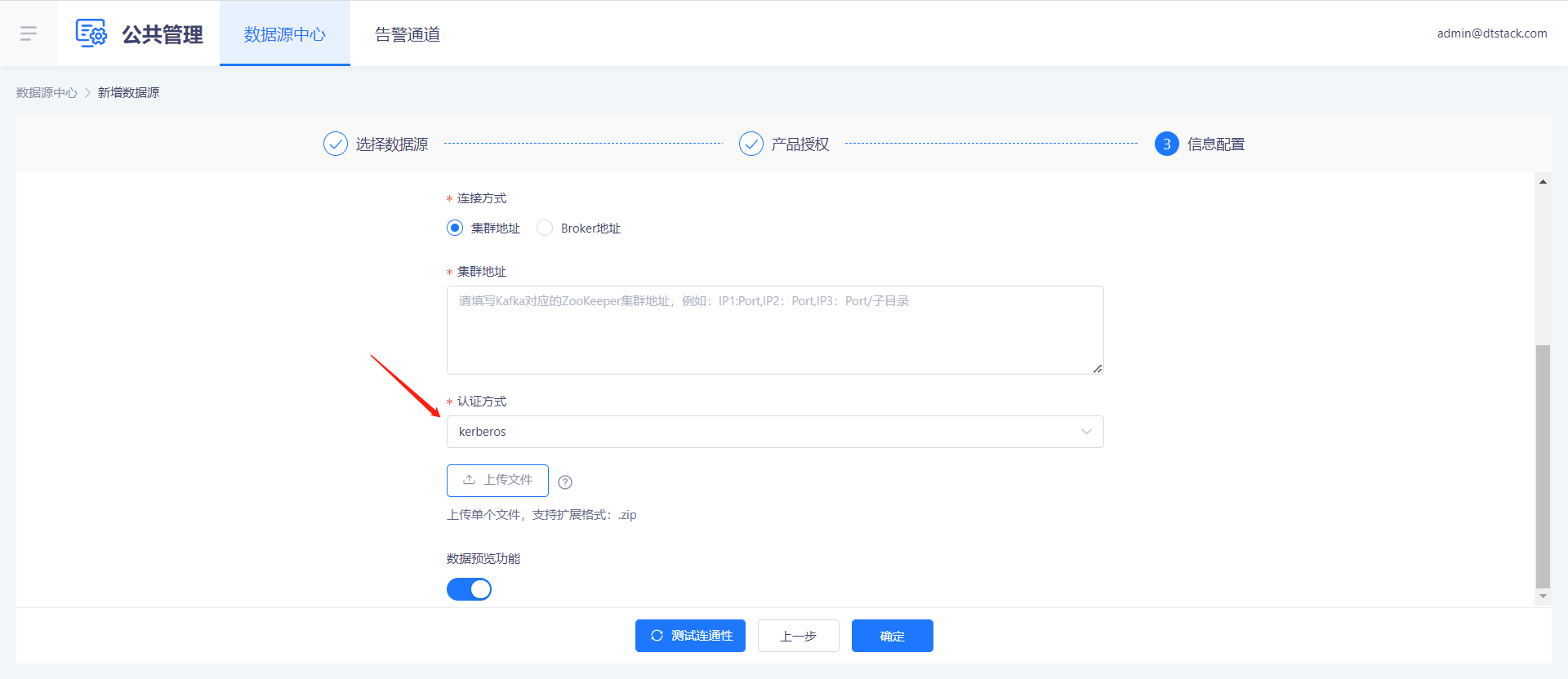

【表管理】Hive Catalog支持开启keberos认证;DT Catalog中的Flink映射表,源表支持开启keberos认证【5.3】

说明:表管理处的Kerberos认证,分为两种程度。

Catalog的认证:此处是通过控制台的Flink组件维护krb文件。(如果hive catalog的hms也自带krb认证文件,平台不做校验)

Flink映射表的认证:支持Flink映射表的源头,如kafka/hbase数据源开启krb认证。(用户需要保障Flink开启的krb认证和表数据源的krb一致,不然任务可能会运行失败)

优化

【Flink版本】Flink版本查询接口直接获取控制台信息,平台不维护【6.0】

- 说明:实时平台几个Flink版本选择的地方,直接查询控制台维护的数据,平台自身不再写死版本号。(如果控制台只添加了1.12,实时平台只显示1.12;如果控制台添加了1.12和1.10,实时平台则显示两种)

【Kafka集群】移除集群管理功能模块【6.0】

- 背景:kafka管理模块后续的定位就是做Topic的增删改查,不会提供集群管理相关的能力。